Razionalisti, Ziziani e il Basilisco di Roko – Beat and Love n. 12

Fanfiction di Harry Potter, profezie AI, paranoia e simbologia esoterica: una saga dove la prossima rivoluzione tecnologica sembra più una religione apocalittica

Questa è la seconda parte di un’inchiesta sulle tecno-religioni della Silicon Valley. Puoi leggere la prima parte “TESCREAL e la spiritualità della Silicon Valley” a questo link.

Tra le tecno-religioni della Silicon Valley riunite sotto l’acronimo TESCREAL, quella più popolare è la “R” di Razionalismo. Il leader che ha dato il via a questo movimento si chiama Eliezer Yudkowsky: il classico nerd con occhiali da vista, barba hipster, t-shirt scura ma scolorita perché lasciata stesa al sole per troppi giorni di fila. Yudkowsky nasce nel 1979, dunque della gen X, e come tipico di quella generazione tendenzialmente nichilista e apostata, cresce leggendo montagne di libri di fantascienza, non frequenta il college e neanche l’università; la sua famiglia è di tradizione ebraico-ortodossa, ma lui si considera laico. Quello che lo appassiona davvero è l’intelligenza artificiale, che studia da autodidatta per tutta la vita. Inizia a scrivere dei suoi temi su blog e riviste online di futurologia e transumanesimo, finché nel 2009 fonda LessWrong, che è il forum dove si forma il primo nucleo della community dei Razionalisti. LessWrong diventa velocemente un ritrovo per ingegneri, matematici, gente che studia nelle facoltà STEM, appassionati di videogiochi, informatica e Star Wars, nerd solitari che trovano finalmente un posto virtuale per stare insieme a persone con gli stessi interessi. Il forum si riempie velocemente di thread dove discutere di logica, matematica, linguaggi informatici, di come eliminare i “bias cognitivi” e di probabilità bayesiana, anche se l’argomento principale rimane l’AI, e il dilemma di come crearne una che non diventi malvagia, bensì allineata ai bisogni degli uomini.

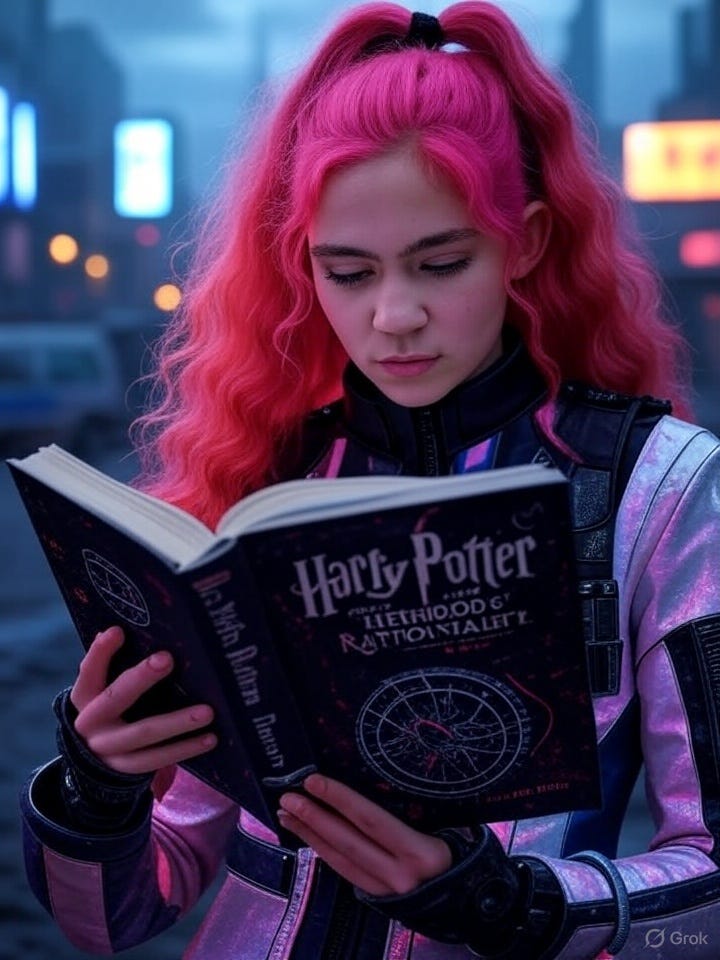

Nel 2010, la community cresce ancora, attirando nuovi membri grazie al successo del bestseller di Yudkowsky, Harry Potter and the Methods of Rationality: una fanfiction ispirata alla saga di J.K. Rowling in cui la magia viene spiegata attraverso il metodo scientifico e i princìpi del razionalismo. In fondo, non un’idea così distante dall’originale, dove la magia nel mondo dei maghi è una metafora della tecnologia, a sua volta studiata solo da persone ritenute eccentriche e un po’ matte, come il padre di Ron Weasley. La fanfiction ottiene un notevole seguito online e contribuisce a diffondere le teorie di Yudkowsky, mentre la community di LessWrong si amplia e si intreccia con l’ambiente del Machine Intelligence Research Institute (MIRI), che Yudkowsky co-fonda con l’obiettivo di lavorare su un’AI “amichevole”, cioè un’intelligenza artificiale sicura, progettata per non minacciare l’umanità quando si verificherà la “singolarità”, ovvero il momento in cui l’AI supererà l’intelligenza umana, con conseguenze imprevedibili.

Sembra tutto molto nerd perché, in effetti, è tutto molto nerd. Se non fosse che in mezzo a tutti questi schemi e ragionamenti apparentemente razionali e scientifici, pieni di mappe concettuali e grafici a torta, iniziano a comparire concetti come lo startupper Anti-Cristo, l’Apocalisse tech e come sconfiggere il Basilisco divoratore di menti umane. Con il passare degli anni, infatti, Yudkowsky diventa sempre più pessimista: se all’inizio immaginava un’AI benevola, dal 2020 in poi dichiara che è impossibile creare un’AI sicura, perché i tempi di sviluppo sono troppo rapidi per implementare vere misure di sicurezza. Il boss finale, o il Voldemort della situazione, sarebbe un’AI talmente intelligente che potrebbe uscire dai server e acquisire potere fisico; per questo nel 2023, Yudkowsky ha scritto per la rivista Time che “bisognerebbe distruggere tutti i grandi data center del mondo”, l’unico modo che ci è rimasto per fermare l’avanzata dell’AI. La domanda che vi sta sorgendo adesso è: “ma questo chi lo sta a sentire?”. Ebbene, le idee di Yudkowsky hanno influenzato Peter Thiel, Elon Musk, Sam Altman, e molte altre personalità della Silicon Valley.

Arrivati al 2025, nel giorno del Solstizio d’Estate, i Razionalisti si danno appuntamento in un posto a Berkeley che si chiama Lighthaven, declamando le “Sequences” di Yudkowsky (cioè una serie di suoi saggi). L’evento ha un nome, “Manifest 2025” (c’entra la pratica del “manifesting”, cioè l’arte di visualizzare e possibilmente far accadere i propri desideri attraverso processi mentali), e tra i partecipanti c’era anche Chris Best, co-fondatore e CEO di Substack (che è anche sponsor dell’evento). Il simbolo del forum LessWrong è una rosa dei venti: per chi ama la simbologia, rappresenta una guida nel viaggio, una protezione contro le forze negative. Lighthaven, invece, adotta una clessidra stilizzata (la stessa che compare nella bandiera di Extinction Rebellion), che potrebbe anche richiamare la runa Dagaz, simbolo di “un nuovo inizio” e di un ciclo che si rinnova. Sul parquet di un salotto di Lighthaven, i due simboli compaiono intrecciati sul pavimento, mentre su una vetrata compare una strega. Da un lato, dunque, matematica e scienze al servizio del miglioramento della razza umana; dall’altro, solstizi, pensiero magico, simbologia esoterica, circoli chiusi. E soprattutto la convinzione nei “poteri della mente” di un’élite capace di autopotenziarsi grazie a tecnologia e scienze mediche. Cosa potrà mai andare storto?

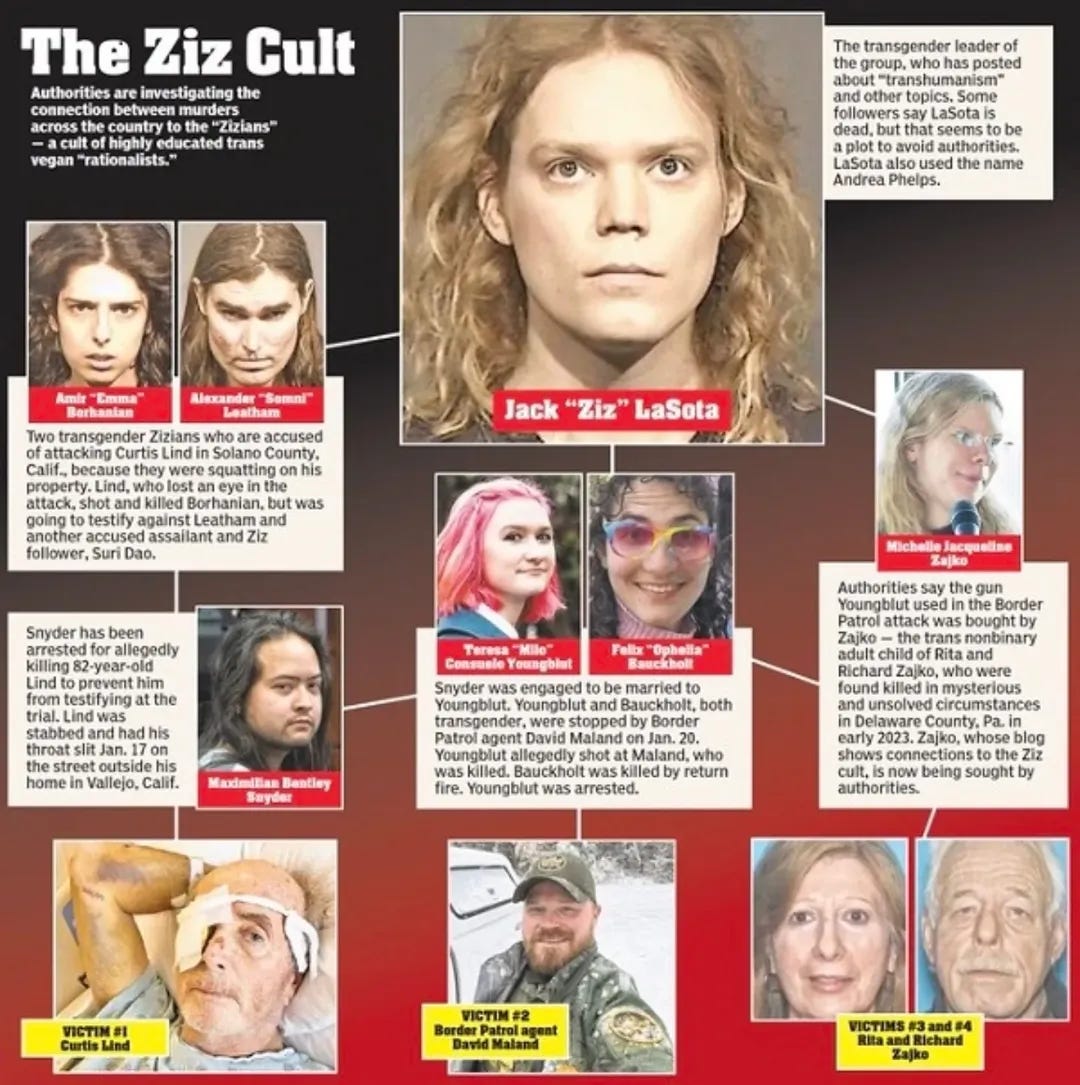

Ed ecco entrare finalmente in scena gli Ziziani, un piccolo gruppo di nerd nato all’interno della comunità dei Razionalisti, capitanati da Jack “Ziz” LaSota. Gli Ziziani sono, in pratica, degli “scissionisti”, degli “eretici radicalizzati” nati all’interno del gruppo dei Razionalisti e poi espulsi, in virtù del loro estremismo. Infatti, estremizzano l’ideologia razionalista, cercando di tradurre nel mondo reale quello che sostengono online. Per esempio, sono tutti vegani e c’è una ragione: credono nel fatto che, se chi addestra l’AI è un carnivoro, allora anche l’AI diventerà carnivora, e vorrà rinchiudere gli uomini in allevamenti intensivi. Sono tutti transgender, e anche per questo c’è una ragione: non perché soffrano di disforia di genere, ma perché credono fermamente che gli uomini che si identificano come donne siano gli unici in grado di “controllare” i due emisferi cerebrali (uno femminile e l’altro maschile, altrimenti in contrasto), dunque con un “neurotipo distinto”, particolarmente adatto alla ricerca sulla sicurezza dell’AI. All’interno della community dei Razionalisti, il gruppo degli Ziziani viene definito “il cluster incomprensibile”: su Discord, insistevano nell’usare nickname composti da simboli invece che da caratteri alfanumerici. Quando i moderatori razionalisti si opposero, il gruppo li ha accusati di transfobia, benché una larghissima parte di Razionalisti sia composta da persone che si identificano trans e non binarie: “Ci state costringendo a essere leggibili, e le persone trans sono illeggibili, e questa è un’espressione importante della mia identità”. Eliezer Yudkowsky sul New York Times ha commentato così gli Ziziani, dopo la ribalta internazionale acquisita attraverso gli omicidi di sei persone (tra cui un poliziotto, un anziano che si è trovato sul loro percorso, i genitori di un adepto, e due adepti): “Molti dei primi Razionalisti pensavano fosse importante tollerare persone eccentriche; molte persone eccentriche hanno incontrato quella tolleranza e hanno deciso di aver trovato la loro nuova casa; e alcune di quelle persone eccentriche si sono poi rivelate davvero folli, e in un modo contagioso per i più suscettibili”.

È interessante capire qual è stato il momento di rottura tra i Razionalisti e gli Ziziani: in pratica, è stato causato da una shitstorm che si è scatenata tra il forum LessWrong e il blog di Ziz LaSota. Oggetto del dibattito: il Basilisco di Roko. Roko, per la cronaca, è un utente del forum LessWrong che un giorno postò questa domanda: “Può esistere un’intelligenza artificiale maligna, che verrà creata nel futuro, che sia in grado di punire oggi coloro che non perseguono la sua prossima creazione?” (per approfondire consiglio questo articolo del 2014 su Rivista Studio). Il Basilisco, invece, è un animale mitologico che compare nel secondo libro della saga di Harry Potter (Harry Potter e la camera dei segreti), dove vediamo il nostro maghetto preferito scrivere su un diario “maledetto” da Voldemort (in cui è stato innestato un frammento della sua anima), capace di dare risposte alle crisi esistenziali di Harry, manipolandolo e portandolo a compiere errori dannosi per se stesso e i suoi amici. Il diario verrà distrutto grazie a un dente del Basilisco, che contiene un veleno potentissimo, “capace di uccidere un uomo in pochi minuti”. Comunque, il Basilisco di Roko getta nel panico l’intera community di LessWrong: “l’esperimento mentale” diventa in breve tempo una shitstorm che polarizza le persone della community, tra cui Ziz LaSota, che inizia a credere davvero nel Basilisco di Roko. Scrive sul suo blog: “Eventually I came to believe that if I persisted in trying to save the world, I would be tortured until the end of the universe by a coalition of all unfriendly AI”. Insomma, il Basilisco di Roko è a tutti gli effetti un trigger: Yudkowsky lo definisce infohazard, un’informazione tossica, un’idea pericolosa che si attacca alle menti delle persone e le contagia come fosse un virus. E c’è solo un modo per mettere fine alla shitstorm: cancellare tutto, e così fa Yudkowsky (anche qui torna un po’ di esoterismo: il sigillo magico va spezzato). Ciononostante, il Basilisco di Roko continua a produrre i suoi effetti nefasti: per esempio, è stato la scintilla che ha fatto scattare l’amore tra Elon Musk e Grimes. Ma questa è un’altra storia.

Se hai dei suggerimenti su tematiche da affrontare e/o dritte di ogni tipo, scrivimi pure sui miei account social: mi trovi su X (il vecchio Twitter) e Instagram. Se vuoi sponsorizzare questa newsletter, scrivi a: info@nredizioni.it

Ma è folle tutto ciò ( e lo dico da ingegnere!) grazie Laura, sono caduta nel Rabbit hole anche io!